Qué es data quality o la calidad de los datos

El data quality o calidad de los datos engloban un conjunto de reglas que permiten asegurar un mínimo en la calidad de los datos que se han recibido para ayudar a que los resultados extraídos sean fiables y de calidad.

Hoy en día se generan millones y millones de datos cada segundo. Muchos de ellos son de mala calidad y solo aportaran errores en nuestro análisis. Es por eso, que cualquier compañía debe tener unos mínimos de calidad en los datos que procesa y analiza.

Características del data quality

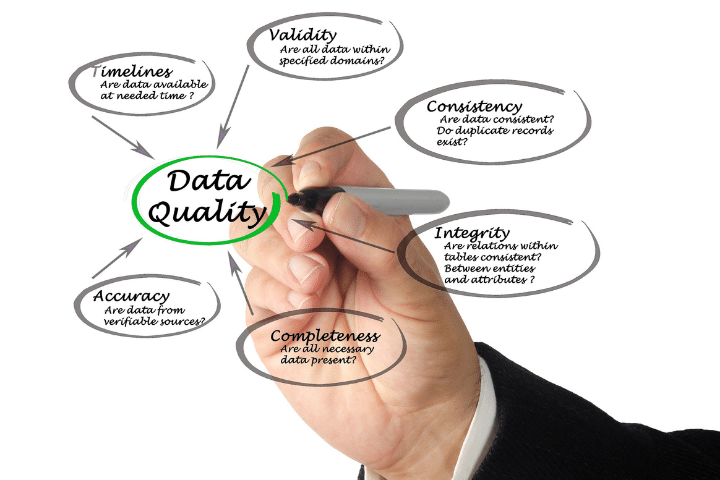

Existen ciertas características o reglas que definen la calidad de los datos de entrada. Seguidamente damos una breve explicación de cada uno de ellos.

Integridad

La integridad se refiere a la capacidad de mantener la correctitud y la completitud de la información en una base de datos. Durante los procesos de ingesta o actualización de datos se puede perder la integridad por el añadido de información no correcta.

Qué es JSON

JSON es una anotación para datos muy utilizada en todo el sector tecnológico en todo el mundo. Aprende qué es y qué usos tiene en el mundo tecnológico.

Ver artículoPor esta razón, es vital cumplir con esta característica para mantener una buena calidad de los datos y podernos fiar del análisis que realicemos sobre ellos.

Exactitud

La exactitud es una propiedad de calidad de datos que hace referencia a la precisión de los valores almacenados y que no den lugar a ambigüedades.

Confiabilidad

Esta propiedad esta directamente relacionada con las dos anteriores y se refiere en que medida podemos confiar en los datos que tenemos almacenados.

Para medir la confiabilidad podemos usar un conjunto de normas y reglas que determinen el grado de confiabilidad y podamos descartar valores poco fiables antes de guardarlos en el data warehouse.

Importancia de la calidad de los datos

El big data y la inteligencia artificial ha llegado ha muchos sectores relevantes para la sociedad como la salud, la economía o el ejercito. Los modelos estadísticos están construidos a partir de una gran cantidad de datos.

Otros posts que te gustarán

Es importante que la calidad del dato sea lo más parecida posible a la realidad. Muchas veces los datos contienen errores y no son del todo precisos. Es por esta razón que es importante tener ciertas reglas que eliminen los datos imprecisos y solo seleccionen aquellos que las cumplen. Aquí es donde entra el “data quality” o calidad de los datos.

Es muy recomendable ir revisando todas las reglas usadas para determinar la calidad de la información y hacer reuniones periódicas para determinar si los datos de los últimos meses necesitan de nuevas reglas de limpieza o no.

Transformaciones de los datos

En muchas ocasiones, los datos que tenemos son correctos. Sin embargo, tienen que ser transformados para que se ajusten bien a lo que requieren los modelos de machine learning.

Un paso fundamental en la creación de modelos estadísticos es la estandarización de la información. Esta normalización se lleva a cabo para que todas las características del modelo tengan valores dentro del mismo rango de números.

En ciertas ocasiones puede ser importante escalar los datos de entrada para que sigan una distribución Gaussiana, ya que es la que mejor se adapta a ciertas técnicas de machine learning.

Otras opciones, son, por ejemplo, la combinación lineal de características o reducción de la dimensionalidad con técnicas matemáticas como PCA (Principal Component Analysis).

Más adelante haremos un artículo explicando las distintas transformaciones disponibles y como podemos aplicarlas a nuestros datos usando la librería de scikit-learn de Python.