O que é qualidade de dados ou a qualidade dos dados

A qualidade dos dados abrange um conjunto de regras que garantem uma qualidade mínima dos dados recebidos para ajudar a garantir que os resultados extraídos são fiáveis e de qualidade.

Hoje, milhões e milhões de dados são gerados a cada segundo. Muitos deles são de má qualidade e apenas contribuirão com erros para a nossa análise. É por isso que qualquer empresa deve ter qualidade mínima nos dados que processa e analisa.

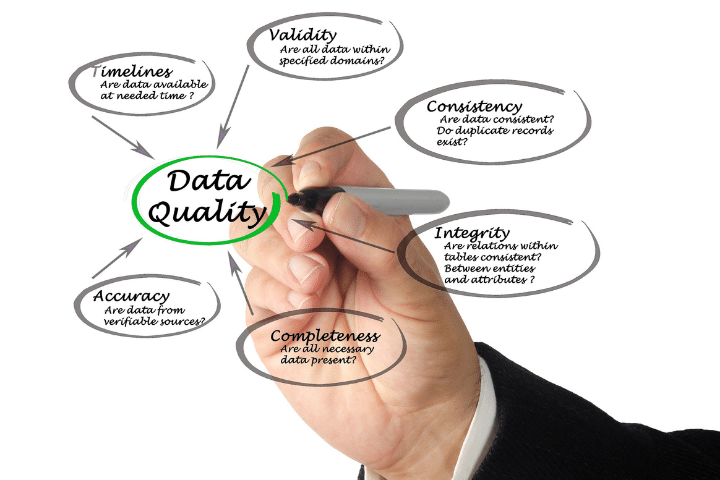

Características de qualidade de dados

Existem certas características ou regras que definem a qualidade dos dados de entrada. Abaixo damos uma breve explicação de cada um deles.

Integridade

Integridade refere-se à capacidade de manter a exatidão e integridade das informações em um banco de dados. Durante a ingestão de dados ou processos de atualização, a integridade pode ser perdida devido à adição de informações incorretas.

Por isso, é vital cumprir esta característica para manter a boa qualidade dos dados e poder confiar na análise que realizamos sobre eles.

Precisão

Precisão é uma propriedade de qualidade dos dados que se refere à precisão dos valores armazenados e ao fato de não gerarem ambigüidades.

Confiabilidade

Esta propriedade está diretamente relacionada com as duas anteriores e refere-se à medida em que podemos confiar nos dados que armazenamos.

Para medir a confiabilidade podemos utilizar um conjunto de padrões e regras que determinam o grau de confiabilidade e podemos descartar valores não confiáveis antes de salvá-los no data warehouse.

Importância da qualidade dos dados

Os grandes volumes de dados e a inteligência artificial chegaram a muitos setores relevantes para a sociedade, como a saúde, a economia ou o exército. Os modelos estatísticos são construídos a partir de uma grande quantidade de dados.

É importante que a qualidade dos dados seja o mais semelhante possível à realidade. Muitas vezes os dados contêm erros e não são totalmente precisos. É por esta razão que é importante ter certas regras que eliminem dados imprecisos e selecione apenas aqueles que as atendam. É aqui que entra a “qualidade dos dados”.

É altamente recomendável revisar todas as regras utilizadas para determinar a qualidade das informações e realizar reuniões periódicas para determinar se os dados dos últimos meses necessitam ou não de novas regras de limpeza.

Transformações de dados

Em muitos casos, os dados que temos estão corretos. No entanto, eles precisam ser transformados para que se ajustem bem ao que os modelos de aprendizado de máquina exigem.

Um passo fundamental na criação de modelos estatísticos é a padronização das informações. Essa normalização é realizada para que todos os recursos do modelo tenham valores dentro do mesmo intervalo de números.

Em certas ocasiões pode ser importante dimensionar os dados de entrada para que sigam uma distribuição gaussiana, uma vez que é a que melhor se adapta a determinadas técnicas de aprendizagem de máquina.

Outras opções são, por exemplo, a combinação linear de características ou redução de dimensionalidade com técnicas matemáticas como PCA (Análise de Componentes Principais).

Posteriormente faremos um artigo explicando as diferentes transformações disponíveis e como podemos aplicá-las aos nossos dados usando a biblioteca Python scikit-learn.