Qu'est-ce que la qualité des données ou la qualité des données

La qualité des données englobe un ensemble de règles qui garantissent une qualité minimale des données reçues afin de garantir que les résultats extraits sont fiables et de qualité.

Aujourd’hui, des millions et des millions de données sont générées chaque seconde. Beaucoup d’entre eux sont de mauvaise qualité et ne feront qu’apporter des erreurs à notre analyse. C’est pourquoi toute entreprise doit disposer d’un minimum de qualité dans les données qu’elle traite et analyse.

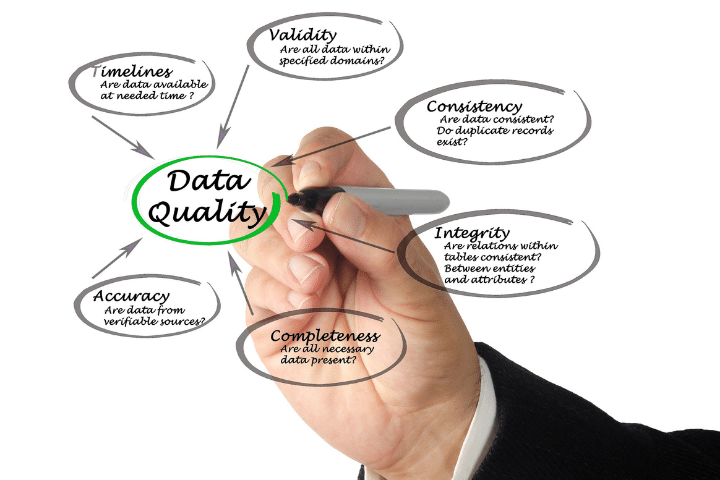

Caractéristiques de la qualité des données

Certaines caractéristiques ou règles définissent la qualité des données d'entrée. Ci-dessous, nous donnons une brève explication de chacun d’eux.

Intégrité

L'intégrité fait référence à la capacité de maintenir l'exactitude et l'exhaustivité des informations dans une base de données. Lors des processus d’ingestion ou de mise à jour des données, l’intégrité peut être perdue en raison de l’ajout d’informations incorrectes.

Pour cette raison, il est essentiel de respecter cette caractéristique pour maintenir une bonne qualité des données et pouvoir faire confiance à l’analyse que nous y effectuons.

Précision

La précision est une propriété de qualité des données qui fait référence à la précision des valeurs stockées et au fait qu'elles ne donnent pas lieu à des ambiguïtés.

Fiabilité

Cette propriété est directement liée aux deux précédentes et fait référence à la mesure dans laquelle nous pouvons faire confiance aux données que nous avons stockées.

Pour mesurer la fiabilité, nous pouvons utiliser un ensemble de normes et de règles qui déterminent le degré de fiabilité et nous pouvons éliminer les valeurs peu fiables avant de les enregistrer dans l'entrepôt de données.

Importance de la qualité des données

Le big data et l’intelligence artificielle ont atteint de nombreux secteurs pertinents pour la société comme la santé, l’économie ou l’armée. Les modèles statistiques sont construits à partir d’une grande quantité de données.

Il est important que la qualité des données soit aussi proche que possible de la réalité. Très souvent, les données contiennent des erreurs et ne sont pas totalement exactes. C’est pour cette raison qu’il est important d’avoir certaines règles qui éliminent les données inexactes et sélectionnent uniquement celles qui les respectent. C’est là qu’intervient la « qualité des données ».

Il est fortement recommandé de revoir toutes les règles utilisées pour déterminer la qualité de l'information et de tenir des réunions périodiques pour déterminer si les données des derniers mois nécessitent ou non de nouvelles règles de nettoyage.

Transformations de données

Dans de nombreux cas, les données dont nous disposons sont correctes. Cependant, ils doivent être transformés pour s’adapter parfaitement aux besoins des modèles d’apprentissage automatique.

Une étape fondamentale dans la création de modèles statistiques est la standardisation des informations. Cette normalisation est effectuée de manière à ce que toutes les caractéristiques du modèle aient des valeurs comprises dans la même plage de nombres.

À certaines occasions, il peut être important de mettre à l'échelle les données d'entrée afin qu'elles suivent une distribution gaussienne, car c'est celle qui s'adapte le mieux à certaines techniques d'apprentissage automatique.

D'autres options sont, par exemple, la combinaison linéaire de caractéristiques ou la réduction de dimensionnalité avec des techniques mathématiques telles que l'ACP (Analyse en Composantes Principales).

Plus tard, nous ferons un article expliquant les différentes transformations disponibles et comment nous pouvons les appliquer à nos données à l'aide de la bibliothèque Python scikit-learn.